Actualisation 8 août 2021

EURÊKA !

Paraphrasant Archimède ou la légende qui lui fit dire "j’ai trouvé !" on peut affirmer que sans les inventeurs, point de civilisation évoluée.

Certains d’entre eux ont rejoint le panthéon du National Inventors Hall of Fame

Cependant à qui devons-nous les inventions de notre quotidien professionnel, auxquelles nous n’accordons pas d’attention ? Comment la conception est-elle venue aux observateurs attentifs que sont les inventeurs ?

Glissons-nous dans une journée type d’un(e) IADE au bloc. Et voyons ce que nous côtoyons sans jamais vraiment nous en soucier.

NDLR : Cet article ne prétend à aucune exhaustivité et n’est pas chronologique dans l’ouverture d’une salle d’opération. 38 inventions sont répertoriées ici.

Les sites consultés : ch.cornouaille.fr, medarus, wikipedia, gralon, linternaute, donnersonsang.com, ophtasurf, revue.medhyg.ch, compilhistoire, medicopedia, MediResource, foulon.chez-alice.fr, avionslegendaires.net, eurekaweb.free, collection.telephones.pagesperso, histoire-image.org, encyclopedie-universelle.com ; planete-echo, bruno.ciccone.pagesperso-orange.fr, lyc58-romain-rolland.ac-dijon.fr, gloubik.info/sciences, grangeblanche.hautetfort, medicantica.com, alain.bugnicourt.free.fr/site/, histanestrea-france.org, société d’histoire de la pharmacie, 1914-1918.be, chaouky.blog.lemonde.fr

SOMMAIRE

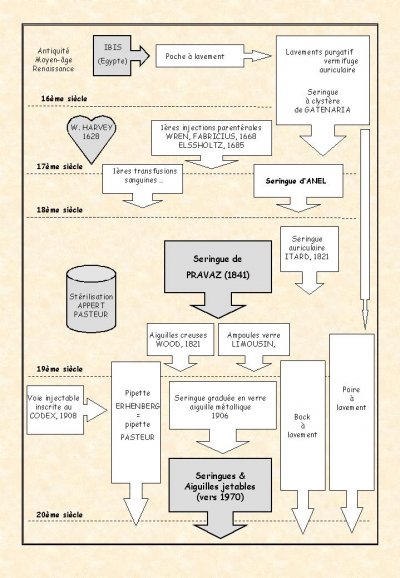

La seringue

Le mot seringue vient du grec ancien syrinx signifiant "tube".

Cette étymologie grecque a aussi donné son nom au seringa, un arbre dont le bois évidé a également servi à faire des injections.

Le mot clystère provient du grec « klustêr », de « kluzein » laver. Ce terme a donné « clyster » en latin.

Le fonctionnement de la seringue aurait été inspiré au naturaliste romain Pline l’Ancien (qui a vécu au Ier siècle) par l’observation des ibis.

Ces oiseaux ont en effet la particularité d’utiliser leur long bec courbe pour s’administrer des lavements à l’eau de mer et faciliter l’expulsion de leurs selles.

Un corollaire de cette nouveauté fut l’invention de la purgation vermifuge . L’administration d’eau sous pression dans le fondement engendra un des premiers exemples d’intervention à but thérapeutique. Fort heureusement, on se cantonna aux cavités naturelles de l’organisme. On attribue à Celse, (Aulus Aurelius Cornelius Celsus 53 av. J.C. 7 après J.C.), la pratique de lavements huileux vermifuges après ingestion de lupin ou d’ail. De même Rufus, médecin grec du premier siècle après J.C., conseillait des clystères irritants vermifuges à base d’eau salée et d’huile de ricin ou de tisane de centaurée, d’absinthe, de lupins ou de résine de cèdre. Quatre siècles plus tard, un médecin à Constantinople Oribase (325-403) conseillait également les lavements vermifuges. Il préconisait l’utilisation d’une canule en corne, aménagée de plusieurs trous sur sa circonférence.

Une seringue à piston aurait été décrite à la même époque. Son utilisation est mentionnée par Philon (environ 230 av. J.C.), médecin à Byzance, pour instiller de l’eau de rose dans le conduit auditif. Celse recommandait également dans son livre « De Medecina » le lavement d’oreille pour combattre les écoulements purulents ou extraire les corps étrangers du conduit auditif externe. Il utilise le vocable « clyster oricularius » même pour évoquer son utilisation en urologie. Puis la seringue pour lavage d’oreille tombe en désuétude et ne sera ré-inventée qu’au 19ème siècle.

Plusieurs millénaires avant notre ère, les lavements intestinaux, vaginaux et auriculaires étaient déjà pratiqués à l’aide de canules rudimentaires en roseau ou en sureau.

Les nombreuses scènes de lavement qui ornent certaines poteries mayas semblent indiquer que des lavements-intoxication étaient pratiqués lors de rituels chez les Mayas. Certaines scènes de vomissements suggèrent que des boissons alcooliques pouvaient être administrées sous forme de lavements. On a expérimentalement démontré depuis l’induction ou l’exacerbation de l’ébriété après administration d’alcool par voie rectale. D’autres scènes suggèrent que le tabac, le lys d’eau (hallucinogène ?) et d’autres plantes à fleurs pouvaient entrer dans la composition des lavements.

Cette pratique médicale perdura jusqu’au XVème siècle où on s’adonnait sans retenue aux lavements intestinaux, vaginaux et d’oreille. On s’aida d’une vessie puis d’une poche en cuir pour servir de réservoir. Un tuyau de roseau ou de sureau faisant fonction de canule rudimentaire. En pressant ou entortillant le réservoir, on expulsait le liquide contenu.

C’est à l’italien Marco Gatenaria que l’on doit l’invention d’une seringue pour administrer les lavements, au XVIème siècle.

D’abord fait en bois puis en métal, cet instrument médical fit l’objet de plusieurs améliorations.

On sait que Léonard de Vinci (1452-1519) pratiqua des injections à visée anatomique dans les vaisseaux, bronchioles et autres cavités à explorer.

En 1668, le médecin hollandais Reinier de Graaf, auteur de « De Clysteribus » invente une tige flexible permettant l’auto-administration du lavement.

Le chirurgien Jean Scultet (1595-1645) publie à Lyon en 1672 « l’Arsenal de la Chirurgie » « Armamentarium chirurgicum » dans lequel il décrit l’emploi de chaque instrument. On y trouve une seringue à lavement avec son tuyau droit (matriculaire) et courbe (auriculaire) ainsi qu’une seringue à clyster avec son petit chapeau et les bougies.

Alfred Franklin, dans « le Médecin charitable » recommande "deux seringues avec leur étui ; l’une pour servir à la maison avec deux canons d’ivoire (= canules), l’un pour donner clystère aux grandes personnes et l’autre pour les petites. On y ajoute un pot d’estain à mettre clystère, pour le garder et faire chauffer lorsque l’on le voudra donner. La seconde seringue se présente avec deux canons de buys, pour prester charitablement aux pauvres quand ils en auront affaire ".

Au XVIIème siècle, on utilise des seringues à lavement dotées d’un tuyau droit ou courbe.

L’homme étant parfaitement « rodé » à l’administration de substances dans les cavités naturelles de l’organisme s’abouchant à l’extérieur, l’idée lui vint de l’effectuer après avoir fracturé la peau. Mais les « avancées technologiques » doivent attendre l’acquisition des connaissances pour ouvrir la voie à de nouveaux domaines.

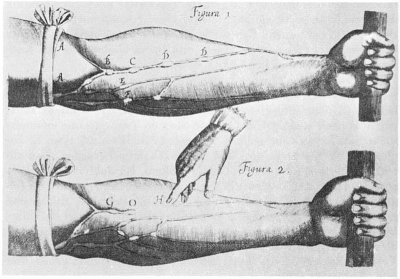

En 1628, la découverte de la circulation sanguine par William Harvey marque une étape décisive dans l’évolution des usages de la seringue.

Enhardis par cette découverte majeure, durant tout le 17ème siècle, les expérimentateurs donnèrent corps au concept d’injection parentérale.

Les premières tentatives d’injections intraveineuses semblent avoir été réalisées par un servant de chasse à courre en 1642, en Allemagne de l’est.

Tout au long du XVIIème siècle, des essais d’injections par voie parentérale sont menés par Christopher Wren, Johann Major, Johan Sigismund Elsholz, Fabricus.

En 1656, Sir Christopher Wren (1628-1694), astronome/mathématicien/architecte à Oxford, injecta par voie intraveineuse différents alcools à des chiens. Schottus raconte qu’à la Cour du Prince palatin Ruppert, un « amusement » consistait à enivrer ou purger des chiens en leur injectant dans les veines du vin d’Espagne ou une liqueur purgative. A cette époque, il n’y avait qu’un pas entre l’expérimentation animale et humaine. Il fut très rapidement franchi. Johann Daniel Major (1634-1693) fut le premier à tenter cette expérience chez l’homme, en 1662 qu’il publia dans le premier livre relatant des injections intraveineuses « Chirurgia Infusoria » paru en 1664.

En 1665, Schmidt réalisa la première tentative de cure de la syphilis par injections intraveineuses

En 1685, Johan Sigismund Elshotz (1623-1688), médecin de l’Electeur de Brandebourg, réalisa les premiers essais infructueux d’anesthésie intraveineuse qu’il relata dans son livre « Clysmatica Nova » en 1667.

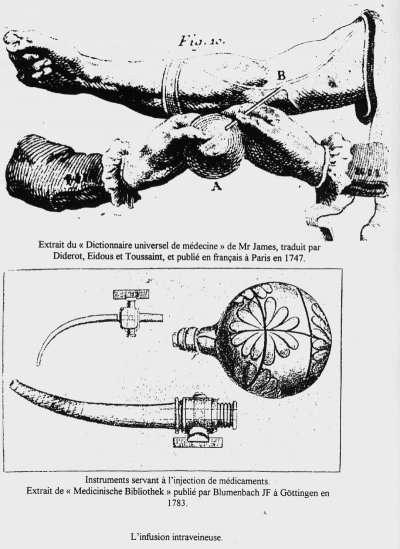

Fabricius en 1668 « voulut expérimenter les effets que produirait l’infusion de quelque médicament dans les veines d’un homme ». Il passa à l’acte en infusant avec un siphon deux dragmes de purgatif dans la veine médiane du bras droit de trois malades. Frédéric Dekkers à Leyde (1695) enseigna l’administration dans l’arrière-gorge de substances médicamenteuses à l’aide d’une seringue et canule en argent, en cas d’angine grave avec difficultés respiratoires. Une illustration figure dans son Traité « Exercitationes praticae circa medendi methodum ». Les instruments utilisés étaient des vessies d’animaux ou des seringues à lavement adaptées. Les aiguilles creuses n’existant pas, la veine était disséquée pour être perforée. Comme les notions d’asepsie et d’antisepsie étaient inconnues, la mortalité excessive de ces expériences les fit tomber en désuétude.

En 1776, le médecin allemand Kohler réalisa une injection dont l’indication perdurera jusqu’au XXème siècle. Chez un patient en état d’étouffement par obstruction œsophagienne, il administra du tartrate d’antimoine par voie intraveineuse, provoquant de violents vomissements salutaires.

Les premières transfusions sanguines furent réalisées au XVIII ème siècle.

L’ancêtre de la seringue hypodermique actuelle est l’instrument mis au point par le chirurgien français Dominique Anel, chirurgien du roi Louis XIV, au début du XVIII ème siècle, sur le modèle des seringues à lavement.

Son traité L’art de sucer les plaies, sans se servir de la bouche d’un homme avec un discours d’un spécifique propre à prévenir certaines maladies vénériennes, jusques à présent inconnu nouvellement invente par le Sr. Dominique Anel est publié en 1707 à Amsterdam. Il y décrit un nouvel instrument, capable selon lui d’aspirer facilement les secrétions.

Cet instrument, basé sur le modèle de la seringue à lavement, mais beaucoup plus petit, était un tube en argent à piston coulissant, dont le corps se terminait par un embout sur lequel pouvaient être vissées différentes canules, sondes ou aiguilles. Mais l’introduction n’était pas si aisée et elle causa beaucoup de blessures aux patients.

Dans « A Medical Dictionary » de R. James paru en 1745, figure une seringue d’Anel et ses sondes.

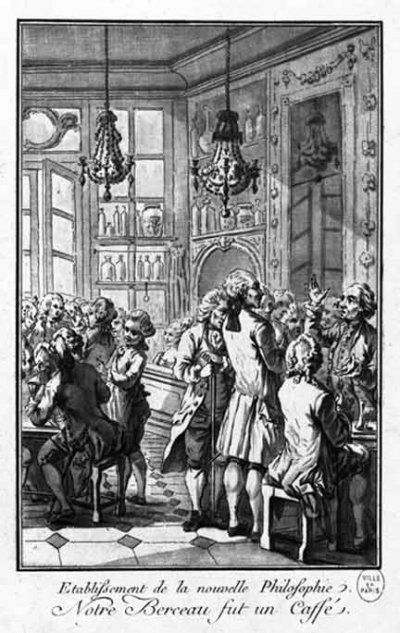

Une illustration de l’Encyclopédie de Diderot et d’Alembert représente une seringue d’Anel munie de son « siphon pour la succion des plaies ». Il s’agit d’une seringue en argent, à piston coulissant, dont le corps se termine par un embout à base carrée sur lequel se vissaient différentes canules, sondes ou aiguilles. Les chirurgiens-barbiers l’utilisaient uniquement pour nettoyer les plaies ou irriguer les cavités naturelles du corps.

Anel écrivit également d’autres traités, qui feront de lui un des chirurgiens les plus réputés de son temps, notamment pour son traitement chirurgical réussi de la fistule lacrymale.

En 1821, Jean-Marc Gaspard Itard (1775-1838), médecin otologiste et chirurgien au Val-de-Grâce, préconise pour la première nouvelle fois, l’irrigation de l’oreille à l’aide d’une seringue dans le but de faciliter l’écoulement d’un excès de cérumen. L’idée est rapidement reprise et appliquée par Beck à Freiburg en 1827, Fabrizi à Modène en 1839 et enfin Schmalz à Dresde en 1846 qui introduisit « le plateau en forme de haricot » chargé de recevoir l’eau de rinçage. Kramer à Berlin (1860) propose un « petit sac en forme de seringue » fabriqué dans un ruban, destiné à l’auto-lavement auriculaire .

Durant environ 200 ans, du milieu du XVIème au milieu du XVIIIème siècle, on chercha quelquefois à fracturer la peau et les parois veineuses à l’aide le plus souvent de plumes d’oie taillées.

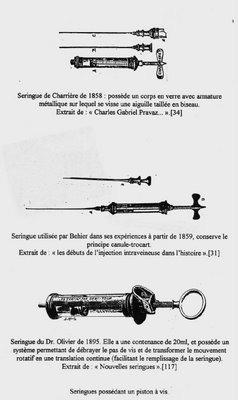

En 1841, un autre chirurgien français, Charles Gabriel Pravaz améliore la seringue d’Anel en l’adaptant aux administrations parentérales précises. Il désirait injecter dans un anévrisme du perchlorure de fer coagulant. Pour ce faire il conçut et fit fabriquer par les établissements Charrière une seringue en argent de 3 cm de longueur et 5 mm de diamètre. Le piston avançait en se vissant, permettant ainsi le contrôle de la quantité de substance injectée ( en l’occurrence 30 gouttes). Canules et trocart étaient en or ou platine. Une fois la canule mise en place à travers le derme du sujet, le trocart était retiré de la canule. Il ne restait plus qu’à visser la canule sur l’embout de la seringue.

Pravaz n’expérimenta que peu, ou pas, sa seringue chez l’Homme. Ce faisant il initia tout de même la sclérothérapie des varices. C’est le chirurgien L. J. Behier qui la dénomma « appareil ou seringue de Pravaz » et en popularisa l’utilisation en Europe.

En 1841, Zophar Jayne (Illinois) invente un dispositif pour le traitement des hernies inguinales par injection de substance irritante dans le sac herniaire. Il s’agit d’une seringue effilée à une extrémité qui, affûtée, peut servir d’aiguille. Une ouverture latérale a été pratiquée dans le corps de la seringue, par laquelle la substance peut être introduite.

En 1845 le chirurgien Irlandais Frances Rynd modifie la seringue dite de Pravaz pour administrer de la morphine par voie parentérale. Il invente un instrument qu’il nomme « Rétractable Trocar ». Cet instrument est basé sur le même principe que le dispositif breveté par Z. Jayne. La morphine avait été isolée de l’opium en 1805 par Frierich Serturner, mais son utilisation retardée de 40 ans.

En 1853, Lenoir de l’Hôpital Necker de Paris, lui apporte deux importantes modifications. Tout d’abord il rend visible la substance injectée en dotant le corps métallique de la seringue d’un fût en verre. Ensuite il visse une fine canule à l’extrémité de la seringue et l’introduit dans le derme à travers la traditionnelle canule, plus large, dont on a retiré le trocart. Les nécessités de la stérilisation vont entraîner des progrès rapides dans la fabrication des seringues. Les seringues doivent pouvoir être démontées rapidement et être composées de matériaux résistants aux procédés de stérilisation. Le cuir du piston va être remplacé par divers matériaux. Straus et Collin vont employer la moelle de sureau. à la place du cuir. Lhomme va se servir de "couches de carton d’amiante et de toile fine cousues serré ensemble" pour réaliser un piston solide et étanche.

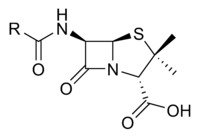

En 1853, l’invention majeure de l’aiguille creuse par Alexander Wood change les possibilités de traitements. Chirurgien à Edinbourgh, Wood utilise une seringue appelée « seringue de Fergusson » pour soulager les névralgies chroniques par l’injection sous-cutanée de morphine au plus près des nerfs affectés. Son corps est en verre d’une longueur de 9 cm et d’un diamètre de 1 cm, terminé par une partie conique et effilée. Son piston en verre est muni d’un joint en coton pour l’ajuster au corps cylindrique non calibré. Ce dispositif nécessite l’utilisation d’une lancette pour fracturer l’épiderme et permettre l’introduction de la partie conique et effilée de la seringue. Wood va modifier cette seringue en calibrant son corps pour améliorer l’étanchéité du piston et ajouter un embout fileté pour visser une aiguille creuse. Wood semble avoir utilisé l’aiguille creuse jusqu’en 1855, sans le publier. Toutefois, son nom est désormais associé à l’invention de l’aiguille creuse.

Mais c’est finalement le système canule/trocart qui s’impose. En 1869, les établissements Charrière, dirigés par Joseph-Frédéric-Benoit Charrière, pérennisent leur fabrication en adoptant le corps de seringue en verre enserré entre deux anneaux métalliques. La même année Lüer, un concurrent parisien de Charrière, apporte deux modifications fondamentales. Il crée un système d’embout conique pour adapter facilement l’aiguille creuse à la seringue. Puis il remplace le piston-vissé par un piston à course libre de type « pousser-tirer » que l’on actionne par une simple pression du pouce. La tige de ce piston est toujours métallique et porte une vis de calibrage dont le réglage permet d’injecter une goutte de produit pour chaque millimètre de course du piston. Le « cône Lüer » aura son homologue sous forme de « cône Pravaz ». Le diamètre moyen du cône Pravaz étant inférieur à celui du cône Lüer, les aiguilles de type Lüer ou Pravaz durent perdurer jusqu’au milieu du XXème siècle ce qui a entraîné pendant des générations des problèmes de connexion entre seringues et aiguilles. Des adaptateurs existaient afin de résoudre ce problème de connexion mais ils se perdaient... La norme internationale n’a retenu que la connexion Luer et le verrouillage a été crée par les américains (Luer–Lock).

Deux avancées vont catalyser l’évolution des injections parentérales. On imagine aisément l’importance de l’invention du brûleur à gaz de R. W. Bunsen qui décupla les possibilités de travail du verre. Mais d’autres facteurs étaient également nécessaires. Il fallait que les idées et les faits évoluent au niveau de l’asepsie et de l’antisepsie. Les travaux de Lister-Koch-Pasteur, et de leurs prédécesseurs plus ou moins célèbres ou obscurs furent primordiaux.

Pasteur étudia d’abord des maladies animales transmissibles par voie buccale (choléra des poules, rouget des porcs, charbon). Mais un jour il eut besoin de faire pratiquer par ses collaborateurs Joubert et Chamberland une administration par voie parentérale.

Il s’agissait d’injecter sous la peau d’un cobaye une culture pure de microbes. Chamberland se rendit aux établissement Lüer, fournisseur d’instruments de chirurgie. Il acheta une seringue de Pravaz. Chamberland (physicien) et Pasteur (chimiste) connaissaient son maniement long, complexe et non stérile, mais aucun n’en avait l’expérience.

Pasteur conseilla à Chamberland de solliciter l’aide d’un jeune étudiant en médecine qui préparait les cours de Duclaux à la Sorbonne. Il s’agissait d’Émile Roux. Ce dernier arriva vers midi. Il prit le cochon d’Inde d’une main et l’inocula rapidement sous la peau. Émile Roux venait de signer son contrat d’embauche avec Pasteur.

Quelques années plus tard, Robert Koch (1843-1910) initia à Berlin le premier cours de microbiologie. (En effet le 1er cours de la Bactériologie naissante française, « Le Grand Cours de Microbiologie » donné par Émile Roux sous la directive de Pasteur à l’Institut du même nom, ne fut donné que plus tard, vers 1880) Cet enseignement récapitulait une longue série de découvertes (cultures pures, Postulat de Koch, bouillon de culture, gélose nutritive, pipette d’Ehrenberg, etc…). Dans ce domaine, Pasteur estima l’événement à sa juste valeur et envoya Emile Roux suivre le premier cours de R. Koch. On imagine facilement la moisson de connaissances que le jeune « stagiaire » engrangea. Il rapporta notamment une « pipette d’Ehrenberg », tube de verre que l’on effile à la flamme d’un bec Bunsen, pour servir à la manipulation des bactéries ou les inoculer à l’animal dans des conditions d’asepsie correctes.

Il s’agit de la fameuse « pipette Pasteur » que tous les biologistes connaissent mais qui aurait dû s’appeler « pipette d’Ehrenberg ». Puis le Dr Emile Roux mit au point une seringue entièrement en verre, donc stérilisable. En forme d’ampoule munie d’une aiguille métallique, son piston était constitué par une tige filetée portant des graduations. Au fur et à mesure que l’on « vissait » le piston dans le bouchon de la partie supérieure de la seringue, on faisait apparaître le volume de liquide injecté. Le Dr Roux l’utilisait pour pratiquer de relatives anesthésies par la morphine. Puis on fabriqua des modèles en verre dont le corps de seringue gradué recevait un piston dont l’étanchéité était assurée par un anneau de caoutchouc entourant sa base.

– La graduation

La graduation va apparaître sur le piston puis sur le corps de la seringue. La seringue "moderne" tout en verre apparaît en 1894, elle est réalisée par un souffleur de verre français Fournier. Elle est rapidement commercialisée par la maison Lüer de Paris.

Ces seringues furent très largement diffusées mais concurrencées par les seringues faites à Berlin par Dewitt et Herz vers 1906.

– Les tailles

Le système de calibrage des aiguilles hypodermiques, cathéters, sondes et fils de suture est basé sur le système anglais de mesure de l’épaisseur du fil de fer. En l’absence de normes officielles, les fabricants définirent des calibres directement corrélés avec les procédés de tréfilage. Ce système a été standardisé vers 1884. Chaque taille du calibrage était exprimée en multiples de 0,001 inches, soit 0.0254 mm.

Joseph-Frédéric-Benoit Charrière a uniformisé l’incrément entre les tailles des calibres (1/3 de mm). Ce système fut connu sous le nom de « French Gauge ». Au début du XX ème siècle, ce calibrage a été modifié par l’adoption du « Système d’Unités International ».

En 1906, on utilise des seringues graduées en verre avec aiguille métallique.

En 1908, la "voie injectable" est inscrite au Codex des pharmaciens et peut donc être utilisée pour administrer des médicaments.

L’ultime révolution qui bouleversa la conception des seringues est l’apparition, vers 1970 de la seringue en Plastique avec aiguille jetable, puis de la seringue entièrement jetable.

Ce modèle finit par s’imposer dans les années 1980 car, outre la stérilité garantie, l’aiguille jetable offre un biseau toujours parfait.

En savoir plus

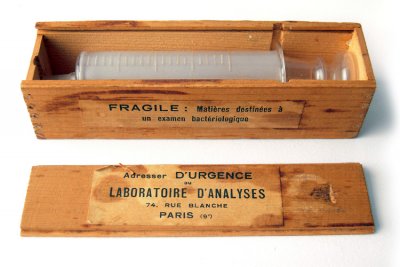

Les ampoules de verre

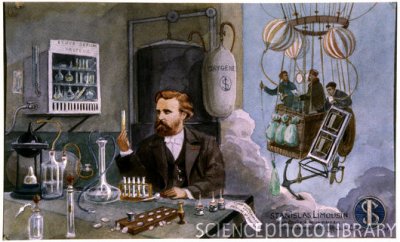

C’est Euphrasie-Stanislas Limousin, un pharmacien français (né le 21 mai 1831 à Ardentes (Indre) et mort le 7 avril 1887 à Paris) qui inventa l’ampoule de verre permettant de conserver les produits injectables.

Inventif, d’une habileté manuelle rare, ce pharmacien rendit un service insigne à sa profession en la dorant de méthodes ingénieuses pour conditionner et préparer certains médicaments. Propriétaire d’une pharmacie, sise rue Blanche, Stanislas Limousin avait vu le jour le 29 mai 1831, à Ardentes, dans l’Indre. Après de bonnes études secondaires au collège de Châteauroux, il avait acquis son diplôme dans la capitale et s’y était établi. De par ses réalisations, il donna très vite une grande extension à sa modeste officine de quartier.

Limousin avait en effet découvert un procédé pratique pour préparer et transporter l’oxygène, que l’on commençait à utiliser en thérapeutique. A la suite de diverses manipulations, il emprisonnait le gaz dans des ballons de caoutchouc cylindriques, ce qui permettait de livrer en tous lieux, pour les soins à domicile ou dans les hôpitaux. Pour les malades qui ne pouvaient se déplacer, Limousin avait installé à côté de son officine une salle d’inhalations où ils étaient traités sous sa surveillance ou celle de leur médecin. Cette nouvelle thérapeutique rencontra un succès immédiat. Limousin fut sollicité de tous côtés.

Ainsi, en 1874, c’est Limousin qui fournit l’oxygène de l’équipage du ballon le Zénith. Ascension dramatique qui coûta la vie à Joseph Croce-Spinelli et Théodore Sivel, qui n’eurent pas le temps de respirer l’oxygène. Seul Gaston Tissandier put le faire et échappa à la mort. Imaginatif, intéressé par tous les problèmes de fabrications médicamenteuses, le pharmacien mit encore au point un procédé pour confectionner et sertir les cachets.

Auparavant l’administration des poudres médicamenteuses se faisait en disposant le médicament au centre d’une feuille de pain azyme humecté dont ont rabattait les bords de façon à former un petit sac que l’on avalait avec un peu d’eau. Les inconvénients de ce mode d’administration étaient grands, éparpillement du médicament et fixation de parcelles de poudre sur les parois de la gorge. Limousin eut l’idée de d’enfermer les poudres dans des feuilles de pain azyme concaves soudées circulairement de façon à former une capsule aplatie. Il modifia plusieurs fois son appareil à cacheter, pour aboutir à l’appareil « cacheteur Limousin », ancêtre de tous les appareils à cachets.

Il inventa les « sucres-tisanes », solubles dans l’eau chaude, des crayons à base d’huile de croton, des vésicatoires, etc. Mais c’est l’invention des ampoules hypodermiques qui fit sa renommée.

Jusque-là, les solutions injectables, popularisées par Dujardin-Baumetz, étaient conditionnées dans des flacons bouchés, plus ou moins stérilisés, ce qui facilitait les cultures microbiennes. Pour y remédier, le pharmacien fabriqua de petites ampoules de verre, terminées par un tube effilé, d’un centimètre-cube de capacité. Une fois stérilisées à 200°C, elles étaient remplies avec des solutions stériles et scellées au chalumeau. L’ampoule injectable venait de naître. Malheureusement, ce grand serviteur de la Pharmacie mourut, en effet, un an après, le 7 avril 1887.

Stanislas Limousin était membre de la Société de Pharmacie (future Académie Nationale de Pharmacie), et fut président de la Société de Médecine pratique et de la Société de Thérapeutique

La perfusion

L’anatomiste et physiologiste Julien César Legallois entrevoit en 1809 la technique de réanimation par l’injection intraveineuse de sang et de liquides susceptibles de le remplacer.

Thomas Latta avec les Dr Lewins et Craigh de Leith, après avoir analysé les travaux du Dr O’Shaughnessy traitent trois cholériques en 1830 par « the copious injections of aqueous and saline fluids into the veins ». Latta jeune médecin injecte avec audace et avec la seringue de Read, 3 litres d’eau additionnée de chlorure de muriate et de sous carbonate de soude afin de compenser les pertes hydroélectrolytiques. La technique va connaître un grand essor au cours des nombreuses épidémies de choléra qui touchent l’Europe tout au long du XIXe siècle. Le succès de la méthode encourage les opérateurs à l’employer avec des produits divers : lait, sucre, ammoniac, sans oublier le chloral qui permet la première anesthésie intraveineuse par le chirurgien Gabriel Oré de Bordeaux.

Le professeur Émile Laforgue à la fin du XIXe siècle, avait émis l’hypothèse selon que le rétablissement de la volémie pouvait éviter un désamorçage cardiaque particulièrement au décours des hémorragies mortelles du post-partum : « une hémorragie peut être mortelle alors qu’il reste encore dans le système circulatoire une quantité suffisante d’hématies pour entretenir la vie ; mais la masse du sang est tellement diminuée et la tension vasculaire si bas déchue, que le cœur, le contractant avide devient impuissant à maintenir en mouvement le sang restant la mort n’est pas due à la dépréciation globulaire subite, mais à l’impossibilité de la circulation. Ajouter à cette masse qui s’immobilise une quantité convenable de liquides, diluez-la avec une solution qui n’altère pas les hématies la vie redevienne possible ; vous donnez le branle au courant circulatoire stagnant, les vaisseaux se remplissent, la pression se rétablit, et le cœur reprend son travail. Une semblable transfusion n’apporte aucun élément vivant : elle n’a qu’une action simplement hydraulique »

Un an plus tard, Joliet et Laffon injectent dans des cas d’anémie aiguë une solution à cinq pour 1000 de chlorure de sodium.

Un an après, Kronecker et Sander en Allemagne préconisent l’emploi d’injections salines dans les hémorragies mortelles.

À Halle Schwatrz en 1881, confirme ces expériences et fixe à 500 ml la dose minimale à injecter chez l’homme.

Bischoff de Bâle la même année injecte de l’eau salée dans un cas d’hémorragie puerpérale grave. Il injecte par l’artère radiale 1250 g d’une solution de chlorure de sodium à six pour 1000 additionnées de potasse caustique.

En France, la solution saline la plus employée est celle qui découle de la formule de Hayem (1884) :

- chlorure de sodium 5 g

- sulfate de soude 10 g

- eau distillée 1000 grammes.

En Angleterre, Ringer en 1880 enrichit ses solutions de bicarbonate de soude, de sels de chaux ou de potasse. Certaines solutions hypertonique se développent comme celle de Chéron proche de la solution de Hayem enrichie de phosphate de sodium.

Les autres indications de perfusion de sérum salé sont :

- les traumatismes graves accidentels ou opératoires,

- les hémorragies intestinales de la fièvre typhoïde,

- les hémorragies de l’ulcère de l’estomac,

- les hémoptysies de la tuberculose,

- certaines hémorragies utérines.

Les premières injections intraveineuses de sucre sont signalées en 1872 par Moutard-Martin et Richet : « le sucre injecté dans les veines est rapidement excrétées par l’urine et provoque une polyurie intense et une sécrétion intestinale abondante » des solutés de glucose apparaissent dans le supplément de 1926 de la pharmacopée française : le soluté de glucose à 5 % qualifié d’isotonique et le soluté de glucose à 30 % hypertonique.

En 1944 les solutés glucosés à 10 % sont utilisés dans les hôpitaux militaires français puis dans les hôpitaux civils après leur importation des États-Unis. Déjà recommandés au début du XXe siècle par les docteurs Salin et Sicard dans le traitement de certains symptômes diabétiques, les solutés de bicarbonate, première solution alcaline luisante, apparaissent dans l’édition de la pharmacopée de 1937 à la concentration de 1,25 %.

À partir des années 50, la réanimation adapte l’apport électrolytique à l’état du patient : sous forme d’ampoules injectables d’ions dans les solutés de base chlorure de sodium et de glucose avant la pause de la perfusion.

En 1890, Schilmmel-Busch relate de nombreux cas d’infection dues à des solutions non stériles ou à des injections pratiquées d’une façon non aseptique. En 1893 dans son traité de chirurgie, le développement des micro-organismes dans l’eau distillée et les solutés injectables, il met en évidence et confirme la nécessité de stériliser les solutés. La stérilisation est déjà plus ou moins bien pratiquée depuis 1872. La commission du Codex publie une méthode de stérilisation dans le supplément de 1895. Ce procédé ne réalise pas encore une stérilisation parfaite puisque la température de l’ébullition à 100° Celsius maintenue pendant un quart d’heure n’est pas suffisante pour détruire les spores.

À partir de 1908 l’emploi de l’autoclave qui n’était utilisée que par l’asepsie chirurgicale améliore la technique de stérilisation. « Lorsqu’on dispose d’un autoclave il est préférable de stériliser le soluté à 110° Celsius pendant 10 minutes en prenant les mêmes précautions pour la sortie de l’air » Des contenants en verre (de la transparence permet un contrôle facile de l’aspect du soluté, de la présence de particules insolubles et de bulle d’air) prêts à être administrés sont progressivement mis au point. Ils seront issus de l’invention des ampoules hypodermiques de Stanislas Limousin (1886). Ces ampoules d’une contenance de 60 à 1000 ml disparaîtront devant les difficultés de fabrication dont l’emploi était prépondérant jusqu’en 1946. La chambre compte goutte inventée par le Dr Haillon élève de Hayem a été incorporée au tube de caoutchouc qui prendre le nom de tubulures de perfusion. Il ne reste plus qu’à inventer le bouchon transposable étanche après perforation. La société Baxter aux États-Unis commercialise en 1931 le premier flacon pour perfusion à bouchon en caoutchouc transperçable, il sera introduit en France en 1945. La tubulure de perfusion équipée d’une prise à air est à usage unique partir de 1950 par l’emploi du polychlorure de vinyl (PVC).

En 1923, le Dr Florence Seibert à Philadelphie donne le nom de pyrogènes à des substances issues de bactéries Gram négatif qui résistent à la chaleur et qui ne sont pas retenues par tous les filtres stérilisants. La fabrication des solutés sera effectuée avec de l’eau distillée fraîchement préparée et le contrôle s’enrichit d’une recherche de pyogènes réalisée sur les produits finis. Les polymères de synthèse qui avait remplacé le caoutchouc des bouchons et les tubulures de perfusion apparaissent dans les contenants de perfusion en 1971 avec la commercialisation aux États-Unis de la poche en polychlorure de vinyle Viaflex par les laboratoires Baxter. Les différents types de poches vont apparaître : poche en éthyl-vinyl-acétate, poche multicouche, poche en polypropylène. Celles-ci vont permettre en 1990 la commercialisation des premières poches industrielles comprenant des mélanges ternaires.

– L’invention du Dr Baxter.

Chacun sait aujourd’hui ce que signifie le mot "baxter" ou le mot "perfusion". Peu de gens savent cependant qu’il fallut une grande découverte, "un moment de génie" pour rendre cette technologie possible pour le plus grand bien de la médecine.

La sérothérapie commença à être utilisée souvent au début du siècle, en particulier pour combattre la diphtérie et le tétanos. La voie sous-cutanée s’imposait pour ces nouvelles thérapeutiques. On utilisait la seringue de Roux, d’une contenance de 20 cm³, reliée à une longue aiguille par un raccord en caoutchouc.

Les premières ampoules scellées firent leur apparition, parfois utilisées sans seringue, à la manière d’une perfusion sous-cutanée. Le Manuel de l’infirmière hospitalière (Masson, 1914) nous apprend qu’il suffit de briser d’un trait de lime les deux extrémités et d’adapter la pointe inférieure au tube de caoutchouc terminé par une aiguille en platine iridié. Durant l’entre-deux-guerres, cette technique d’injection n’a pas beaucoup évolué bien qu’on ait perfusé des solutions liquidiennes en quantités de plus en plus importantes.

L’occupation allemande nous coupe alors de toute information quant aux progrès de la médecine réalisés hors d’Europe. On en reste donc à la méthode classique de perfusion décrite dans le traité de « Petite chirurgie » du médecin-général français J. Maisonnet (1942) :

– les solutions seront introduites dans l’organisme à une température de 35–40 degrés et donc réchauffées si besoin au bain-marie,

– pour l’injection sous-cutanée de sérum, il faut une aiguille de longueur et de calibre suffisants (8 à 10 cm) adaptée à un tube en caoutchouc lui-même fixé à un récipient contenant le sérum,

– le récipient peut être soit un bloc d’Esmarch, soit un flacon à double tubulure fonctionnant comme un siphon ou par renversement. Dans ce procédé, on utilisera pour faciliter la pénétration du liquide l’augmentation de la pression de l’air d’une soufflerie de Richardson.

Le choc pyrogénique freine l’emploi des solutions aqueuses en perfusion.

Tout médecin qui voulait perfuser un patient soupirait devant la complication de la méthode. La solution à perfuser devait être préparée par le pharmacien, stérilisée, puis versée à bonne température dans un bock ou dans un flacon à double tubulure. Le contact de l’air avec le liquide perfusé et la méthode de Richardson favorisaient la dispersion des poussières aériennes dans le liquide. Les complications post-perfusionnelles sont fréquentes, la plus redoutée étant le choc pyrogénique qui survient surtout pendant la perfusion intraveineuse.

Le vocable « pyrogène » a été créé en 1924 par Seibert et désigne des substances dissoutes dans les solutions injectables, capables de produire une poussée d’hyperthermie après une injection intraveineuse. Ce phénomène a été bien étudié par le professeur Hustin, pionnier de la transfusion sanguine en Belgique. Il se manifeste par de la température, des frissons, des lombalgies, céphalées et vomissements, quelle que soit la substance pyrogénique employée ( vaccin anti-typhoïde, gonovaccin, solution de glucose, ou d’eau salée physiologique).

Les substances pyrogéniques résultent du développement de microorganismes variés, qui apparaissent même dans de l’eau distillée. La stérilisation ne les fait pas disparaître et l’examen bactériologique ne permet pas de déceler si une solution est pyrogénique ou non.

En 1942, la pharmacopée américaine a établi un test étalon pour déterminer la présence de substances pyrogènes dans une solution. C’est le test des lapins. Cinq animaux doivent être employés pour la même expérience. Après injection, un écart de température de 0,6° au moins doit être noté chez deux des lapins pour que la solution testée soit considérée comme pyrogénique.

Pour qu’une solution ne contienne pas de pyrogènes, le professeur Hustin conseille de n’employer que de l’eau fraîchement distillée, car il suffit de la maintenir quelques heures à température ambiante pour qu’elle développe des substances pyrogéniques.

On comprend que les médecins d’avant-guerre, aient longtemps restreint au maximum les perfusions intraveineuses. Et voilà que début 1940, la firme Christiaens fait paraître à ses frais un petit livre écrit par le docteur M. Ferond qui s’intitulait Le médecin devant le péril aérochimique. Ce livre contenait les premières publicités de la firme Baxter concernant ses solutions stérilisées sous vide Vacoliter. Ce système garantissait enfin au médecins des perfusions sans réaction thermique, quelle que soit la composition de la solution employée. Les photos de ce matériel révolutionnaire, dont Christiaens venait d’obtenir le monopole de distribution pour la Belgique, faisaient mesurer aux médecins l’avance prise par la technique des perfusions aux Etats-Unis. Ces premières publicités pour les solutions sous vide n’eurent cependant pas de suite immédiate car peu de temps après la guerre coupera les liens commerciaux de la Belgique avec l’Amérique. Il faudra attendre la victoire alliée pour voir la propagation de cette innovation médicale extrêmement importante.

L’inventeur des solutions sous vide : Le bon Dr Baxter.

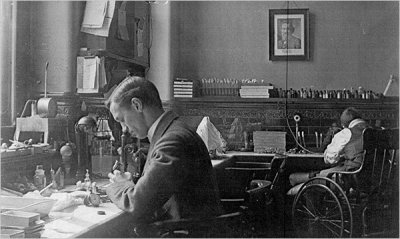

Donald E Baxter est né à Southington (Ohio) en 1882. Après des études d’ingénieur civil, il obtient son diplôme de médecin en 1909. Engagé par la fameuse Rockefeller Fundation, il s’occupe de la mise au point des techniques de revalidation pour les victimes de la poliomyélite, puis il sert en France comme médecin militaire pendant la première Guerre mondiale. Démobilisé, il part en Chine, toujours pour le compte de la Rockefeller Fundation, afin de porter assistance aux victimes du choléra. C’est durant ce séjour qu’il aurait inventé le premier plan incliné destiné à faciliter l’accès aux bâtiments aux handicapés en voiturettes.

Atteint de tuberculose, il doit écourter son séjour et rentrer aux Etats-Unis. En 1921, il crée un laboratoire de produits médicaux à Glendale (Californie). Il y développe toute une série de produits novateurs : des bouteilles d’oxyde d’azote pour l’anesthésie, des équipements radiographiques, des produits anticonceptionnels et même des cosmétiques.

Il suit de près la littérature médicale. Son attention est attirée en 1923 par un article du Dr Seibert Florence, de l’Association Nationale contre la Tuberculose. Ce médecin décrit les graves réactions de ses patients aux substances pyrogènes contenues dans l’eau distillées, même après stérilisation. Pour le Dr Baxter, c’est le point de départ de recherches visant à mettre au point une technique qui rendrait toute solution liquide apyrogène.

En 1928, il expérimente sur lui-même en s’injectant un liquide stérilisé sous vide. La solution reste apyrogène : c’est le succès et un progrès indéniable.

Un an plus tard, il commercialise timidement ses solutions sous vide. Travaillant à très petite échelle, le succès eut été lent à venir sans sa rencontre avec les frères Falk. L’histoire de cette collaboration vaut la peine d’être contée. Harry Falk est un commerçant avisé mais malchanceux : la dernière entreprise qu’il vient de fonder – la Popatocrat – s’est engagée auprès des détaillants de l’Est du pays à leur fournir des pommes de terre d’Idaho dans un parfait état de fraîcheur. L’idée, excellente en soi, demande une logistique compliquée et le succès se fait attendre. Philosophe, en attendant que le projet mûrisse, l’homme d’affaire collabore avec le Dr Baxter pour la diffusion et la vente de ses cosmétiques. Quant il voit le chercheur se focaliser sur ses solutions apyrogènes, il se demande si de tels produits pourraient engendrer un marcher important. Il montre quelques échantillons de solution sous vide à son frère, médecin à l’hôpital St Joseph à Boise, qui les teste dans son service et dans ceux de ses confrères.

Le Dr Ralph Falk est vite convaincu à la fois par le produit et par son frère d’investir dans cette invention. La confrontation des idées d’un médecin praticien, d’un médecin théoricien et d’un commerçant avisé, débouche en octobre 1931 sur la création de la Don Baxter Intravenous Products Inc.

Les capitaux de Falk permettent à l’invention de Baxter de prendre son envol. Il est vrai qu’elle arrive au bon moment : les progrès récents en chirurgie et en thérapeutique médicamenteuse réclament des voies d’accès plus sûres au corps humain. La perfusion de liquide est de plus en plus employée comme moyen thérapeutique mais, pour éviter le choc pyrogénique, elle s’effectue par voie sous-cutanée avec une longue aiguille. La procédure requiert la surveillance par un médecin et une infirmière au chevet du malade pendant une heure ! Ce nursing limite fortement les demandes de perfusion.

En 1931, la société Baxter dépose le brevet de son Vacoliter Containent. Un an plus tard, s’étant rendu compte de la difficulté de vendre au « porte à porte » aux hôpitaux. Harry Falk parvient à conclure un contrat avec une société de distribution de produits médicaux déjà bien en place : The American Hospital Supply. La partie n’est pas encore gagnée. Il faut sans cesse améliorer le produit et arriver à produire à grande échelle. Les multiples problèmes sont résolus rapidement, sans grands moyens mais avec beaucoup d’ingéniosité. Ainsi, on s’aperçoit que de microscopiques particules de verre détachées pendant le transport peuvent rendre le liquide turpide. Le Dr Nesset, nouveau collaborateur de la jeune société, règle la chose par un traitement des flacons au dioxyde de souffre. Un autre collaborateur, le Dr Cherkan, parvient à traiter le bouchon de caoutchouc afin qu’il ne réagisse plus avec la solution. Il invente pour ce faire une huile dont la formule est toujours gardée secrète.

Du côté des hôpitaux, il faut sans cesse convaincre et ce rôle est dévolu aux premiers délégués pharmaceutiques engagés. Il faut persuader les médecins que le surcoût des solutions sous vide est compensé par un moindre coût du nursing, faire des démonstrations. Certains hôpitaux se plaignent de réactions imprévues attribuées au Valcoliter. Il s’agit bien souvent de contaminations microbiennes dues à la mauvaise désinfection de la tuyauterie en caoutchouc et de l’aiguille. Des solutions deviennent turpides sans raison apparente pendant un hiver rigoureux. Les reprenant dans sa voiture pour les faire analyser, le délégué s’aperçoit à l’arrivée qu’elles sont redevenues limpides : le froid avait simplement précipité le dextrose. On spécifie des normes de stockage.

En 1934, le Dr Baxter revend ses 40% de parts aux frères Falk. Il décède l’année suivante d’une hémorragie cérébrale, à 53 ans.

En temps de guerre comme en temps de paix.

Les opérations de la seconde Guerre mondiale ont mis en lumière la valeur de l’invention du Dr Baxter et assuré le succès de sa société. En 1939, le système de conservation du sang sous vide est breveté par la firme Baxter sous le nom de Transfuso-Vac. En 1941, c’est le plasma qui est à son tour conservé sous vide. A la fin des hostilités, 1,2 millions de Transfuso-Vac et de Plasma-Vac Container, et 4,3 millions de Valcoliter avaient été livrés à l’armée américaine. Les nouvelles techniques de transfusion ont fait leurs preuves. On estime que moins de 5% des soldats américains blessés au front perdirent la vie, alors que 10% des soldats allemands décédèrent des suites de leurs blessures.

Les liquides de perfusion stérilisés sous vide sont arrivés chez nous en 1944 avec les médecins militaires ayant appartenu aux forces belges en Grande-Bretagne. Un jeune confrère, le Dr H. Reynholt, qui opéra trois semaines comme anesthésiste en 1944, se souvient du savoir-faire remarquable qui régnait dans le Service de Santé britannique, où appareillage et produits pour transfusions et perfusions étaient disponibles à la demande. Se retrouvant plus tard à l’hôpital Longchamp à Bruxelles, il s’efforça d’obtenir des équipements tout aussi performants. On imagine les difficultés d’un jeune médecin idéaliste revenant de récentes opérations militaires, face à des chefs de service plus âgés et encore installés dans les habitudes d’avant-guerre ! Encore fallait-il aussi former le personnel paramédical aux nouvelles techniques. Le Dr Reynholt en fit l’expérience l’an dernier encore, quant il demanda à l’infirmière responsable de son service de commander un stock de sérum physiologique destiné à être perfusé. Quelque temps après, alors qu’il réclamait son stock, celle-ci ouvrit une main protégeant six ampoules de sérum physiologique et lui dit candidement : « Je crois que cela suffira pour un certain temps, docteur… »

C’est donc avec une certaine lenteur que les perfusions au moyen de solutions stérilisées sous vide se généralisent dans nos hôpitaux. Le progrès est toutefois inarrêtable et le nombre de patients sauvés est là pour en témoigner.

Un complément sur le sujet à lire sur le toujours excellent site du CHAR

Le respirateur

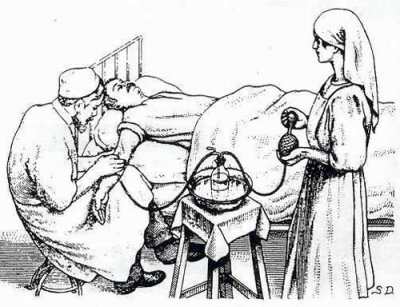

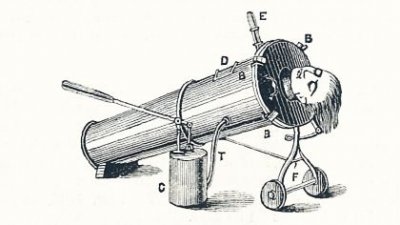

En 1876, le Spirophore d’Eugène Woillez a été le premier ventilateur par application externe d’une variation de pression.

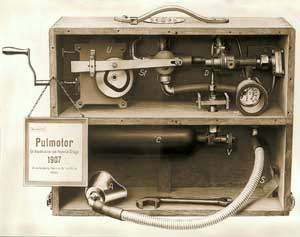

Le Pulmotor d’Henrich Dräger (1906) est l’ancêtre des ventilateurs barométriques et des modes à pression préréglée.

Le concept fut inventé par Philip Drinker qui popularisa le poumon d’acier suite à l’épidémie de polyomyélite des années 1940 à 1950.

C’est au danois Bjørn Ibsen, père fondateur des soins intensifs et héros de l’épidémie de poliomyélite de Copenhague en 1952, que l’on doit le passage à un respirateur en pression positive, qui n’est pas pour autant le plus physiologique.

La spécialité de soins intensifs a commencé à Copenhague en 1952, lorsque Bjørn Ibsen a obtenu de pouvoir faire un relais mécanique de la ventilation manuelle d’un patient de 12 ans mourant de la polio.

Ibsen a travaillé comme anesthésiste indépendant car il n’y avait pas de postes disponibles !

Fils d’un vendeur, il avait été élevé à Copenhague. A l’obtention de son baccalauréat en 1933, il entre à l’Université de Copenhague, et en sort en 1940. Dans sa dernière année d’études, il a donné sa première anesthésie, en utilisant "l’équipement standard" :un sac d’éther, pince pour la langue, et un ouvre bouche.

En règle générale, les anesthésiques été délivrés sous la supervision du chirurgien par une infirmière ou un étudiant.

Dans un hôpital de la région du Jutland il a été formé en radiologie, chirurgie, pathologie et gynécologie. Pour seul équipement anesthésique, un inhalateur d’Ombredanne.

Il gagna un prix en biochimie en 1944. Il est allé au Massachusetts General Hospital en 1949 pour sa formation spécialisée en anesthésie.

Sa femme, Ingrid, une infirmière, l’a accompagné sur le voyage en bateau ; sur le bateau du retour, elle a rencontré Mogens Bjømboe, adjoint de Hans Christian Larssen, chef de l’Hôpital Blegdams Fever.

Ce fut le début de leur collaboration.

Pour autant, on associe également un autre découvreur, au concept du respirateur : Forrest Bird, inventeur des premiers respirateurs médicaux, produits de "masse" à faible coûts, fiables.

Il est né à Stoughton, Massachusetts le 9 juin 1921. Son père, un pilote de la première guerre mondiale, l’a encouragé à voler et à l’âge de 14 ans, en analogie à son nom de famille, le jeune Bird pris son premier vol en solo dans un avion. En 16 ans, il travaillait à plusieurs projets de certifications pour pilotes de haut niveau.

Quelques années plus tard, Bird entra à l’Army Air Corps et, au cours de la Seconde Guerre mondiale, il devint officier de l’air s’occupant de la formation technique. Durant cette période, les avions, volant plus haut que jamais, dépassaient l’altitude à laquelle les pilotes pouvaient respirer sans aide. Bird développa une technologie qui pourrait aider à respirer les pilotes. Après qu’un médecin de l’Air Corps lui eut présenté des manuels sur la physiopathologie des mammifères, il se passionna pou le sujet.

Bird fut assisté d’un certain nombre de facultés de médecine. Cette connaissance l’amena à développer le prototype de Bird Universal Medical, des respirateurs pour les soins cardio-pulmonaires aiguës ou chroniques.

Bird a fondé la Bird Corporation en 1954 pour commercialiser et développer son dispositif. À partir de 1958, il testa ses appareils dans les écoles de médecine, et s’appuya sur les médecins à qui il demanda de lui présenter les cas les plus graves d’insuffisants cardio-pulmonaire, qui n’avaient plus aucun espoir après échec de toutes thérapies.

Dans certains cas, les patients impliqués dans les études de Bird, moururent, mais par de nombreuses fois ils survécurent.

Son modèle respiratoire, réussi. Ses petits appareils verts s’implantèrent rapidement dans les hôpitaux à travers le monde. En 1970, Bird a présenté le "Babybird" respirateur, ce qui a réduit la mortalité infantile due à des problèmes respiratoires de 70% à moins de 10%.

Bird sera président de l’association de l’aviation civile médicale, il intègre le hall of fame des inventeurs en 1995 et membre de la loge maçonnique de Palm Springs.

Il meurt le 2 aout 2015, dans sa maison de Sagle dans l’Idaho.

De nos jours, les respirateurs sont multiples.

On peut citer parmi les plus anciens et les plus connus, sans aucun souci de publicité, le RPR (CAR 830), le bear one, le bird, le servo 900 (B,C, D), l’aestiva 7800 et 7900, le julian, l’excel 210, le SA1 et SA2, le narkomed, le kontron ABT 4100 et 4300, le cato, l’alys, le julian, le fabius, le primus, le zeus...

NB : A visiter le musée du CHU de Grenoble (pour ses iconographies et ses photos "vintage" cultes. Un must !)

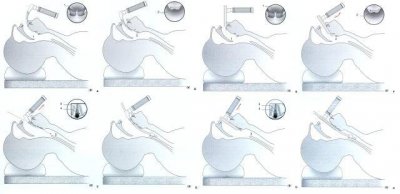

La sonde d’intubation

L’anesthésie générale est aujourd’hui la forme d’anesthésie la plus souvent appliquée. Elle représente plus de 80% de l’art anesthésique des différentes spécialités chirurgicales hospitalières. La technique de l’intubation endotrachéale a déjà plus de 1000 ans. Au début de notre siècle, toutes les conditions avaient été données pour une performance largement répandue et sécuritaire de l’intubation endotrachéale. Toutefois, l’histoire s’est construite au fil des siècles, avec ses étapes les plus importantes dans le développement de cette aide essentielle à l’anesthésie :

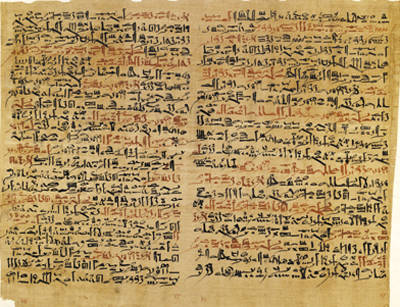

Dans l’Antiquité Égyptienne, Grecque et Romaine, seuls de rares récits de tentatives de ranimation de personnes présumées mortes nous sont parvenus.

– Hippocrate (-460 à –377) aurait proposé, en cas de suffocation, d’insérer un petit tuyau dans la gorge du patient pour y insuffler de l’air. Pour certains ce serait la description d’une trachéotomie, pour d’autres, plutôt celle d’une intubation

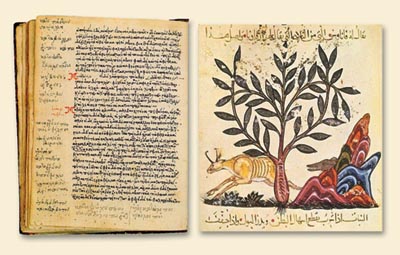

On prête au médecin Persan Avicenne (980 à 1037) les premières intubations trachéales en cas de suffocation, à l’aide de canules d’or ou d’argent (Livre III du Canon de la médecine (Kitâb al-Qânoun fi al-Tibb))

– 1543, Andreas Vesalius dit André Vésale (1514-1564)

Médecin flamand,

"Père de l’anatomie moderne" dans son " Humani Corpores Sanita " décrit la ventilation artificielle en pression positive à thorax ouvert sur un animal à l’aide d’un roseau introduit dans la trachée. Tombée dans l’oubli, cette méthode ne sera réinventée que 350 ans plus tard lors de la naissance de la chirurgie thoracique.

– Paracelse introduisait un soufflet dans la bouche pour ressusciter les asphyxiés.

– 1667, Robert Hook démontre l’hématose et la respiration tissulaire.

– 1744, publication dans " Medical Essays " ventilation avec succès par bouche à bouche chez un patient asphyxié par gaz carbonique.

– 1754 Benjamin Pugh réanima les nouveaux nés avec un tuyau de 25cm et d’un diamètre de la taille d’un plume de cygne. Il l’introduisait avec les doigts dans le larynx.

– 1755, invention du double soufflet de Hunter qu’il améliorera en 1776 en ajoutant une valve d’échappement.

– A partir de 1767, l’insufflation pulmonaire fait partie des moyens thérapeutiques de la ranimation des sujets en mort apparente. La création de sociétés philanthropiques (Amsterdam : 1767, Venise et Milan : 1768, Paris : 1772, Londres 1774) diffuse la technique (très discutée) par bouche à bouche, canule de PIA …

– En 1780, Chaussier invente son tube laryngé pour la réanimation des nouveaux nés en état de mort apparente

– En 1786 Nooth invente un appareil avec un cylindre de cuivre et en 1789 Gorcy invente la pompe apodopnique (qui rétablit la respiration), suivie en 1790 par celle de Heus Courtois.

– 1788 Charles Kite invente un tube pour passer dans la glotte.

– 1792 James Curry les instruments nécessaires au sauvetage des noyés où il apparaît un tube laryngé avec un système de blocage.

– 1806 : François Chaussier qui réanimait les nouveaux nés avec un masque et de l’oxygène propose son tube trachéal qui sera par la suite modifié par Depaul en 1845 et par Ribemont en 1878.

– A partir de 1827, à la suite des travaux de Leroy d’Etiolle, après la publication d’un pneumothorax suffocant gravissime, l’insufflation va subir une terrible éclipse. Celui-ci met en évidence le danger de l’hyperpression pulmonaire. Il indique des précautions à prendre, crée un soufflet à volume réglable et veut interdire l’insufflation par des profanes. Mai interprétés, ces expériences ont jetées le discrédit sur l’insufflation pendant 50 ans

– A partir de 1845, Depaul commence à réhabiliter la ventilation chez le nouveau né.

– 1848 Bouchut et Snow utilise l’intubation dans le croup et plus tard pour les anesthésies animales

L’ancêtre du poumon d’acier est le Spirophore du Dr Woillez mais il resta au stade de prototype de laboratoire.

– En 1869, Trendelenburg invente le ballonnet gonflable sur le tube trachéal

Première utilisation chez l’homme d’une canule de trachéotomie par Friedrich Trendelenburg.

– 1871 Trendelenburg invente la canule de trachéotomie avec ballonnet gonflable.

– 1875 : aérophore pulmonaire du Dr Gayral, l’insufflateur du Dr Pros, le tube laryngé de M. Ribemont

– 1878 William Mac Ewen de Glasgow se sert de tube trachéal en cas d’œdème de la glotte.

– 1880 : Première intubation orotrachéale pour l’anesthésie par William MacEwen.

– 1885 Le pédiatre américain Joseph O’Dwyer (1841-1898) de New-York suit les traces de Bouchut et Snow pour les diphtéries et améliore sa canule pour le ventilateur de Fell. À l’origine, les premières intubations trachéales ont été réalisées lors des épisodes asphyxiques de la diphtérie. Jusqu’à la fin du XIXe siècle, la seule chance de salut était de réaliser une trachéotomie, alors grevée d’une lourde mortalité. O’Dwyer a inventé la méthode d’intubation qui porte son nom et qui a été publiée en 1887 dans le N. Y. Medical Journal sous le titre ", J. O’Dwyer, “Intubation Of The Larynx, With Demonstration On A Cadaver”, Transactions of the Medical Society of the State of New York, page 323 :, et qui fut lut à la société médicale de l’état de New York en février 1888.

« Avant de procéder à démontrer la méthode de pratiquer l’intubation du larynx sur ce cadavre peu, je vais soumettre à votre inspection quelques-unes des principales variétés de tubes conçus pour surmonter l’obstruction dans le larynx dans le croup et d’autres formes de sténose. Ils servent à montrer les différentes étapes de développement à travers lequel cette opération a passé depuis sa création en janvier 1880 à l’heure actuelle ».

L’intubation oro-et nasotrachéale a été développé comme l’une des techniques les plus importantes en anesthésiologie. A l’origine, les intubations ont été réalisées pour surmonter une obstruction aiguë diphtérique chez les enfants. A la fin du XIXe siècle, la seule chance de survie été d’effectuer une trachéotomie. Bien que la technique pour cette opération se soit bien développée, il était très souvent impossible de sauver la vie de ces patients moribonds. Le pédiatre américain Joseph O’Dwyer ré initia la technique de l’intubation et de par ses excellents résultats elle fut encouragée et pratiquée dans le monde entier, même si elle était une procédure bien connue à cette époque. En collaboration avec le chirurgien Georges Fell, O’Dwyer conçu un appareil, pour la respiration artificielle. Il a été largement utilisé dans les cas d’asphyxie, même dans ceux causés par un surdosage d’anesthésiques. D’autres développements de l’appareil permettent une ventilation à pression positive et la combinaison avec un entonnoir pour les stupéfiants a augmenté le répertoire des possibilités d’anesthésie.

– Après 1856 et durant trois décennies, Marshall Hall combattit les « méthodes de forçage" et de soufflet pour la ventilation artificielle ; la "respiration forcée humaine" (équivalent à une ventilation à pression positive intermittente) fut pratiquement abandonnée. Les diverses manœuvres de mobilisation des bras sur la poitrine se sont souvent révélées insuffisantes pour sauver la vie.

– Le médecin et ingénieur George Fell, de Buffalo (New York) (1849-1918), échoua à sauver la vie d’un patient en surdosage d’opiacés en utilisant la méthode populaire de Silvester, il résolut de tenter sa méthode de ventilation (soufflet et une trachéotomie) sur des animaux de laboratoire.

Après son premier succès en 1887, il adapta au mieux son appareil en vue de l’utilisation sur l’homme, et s’attaqua à des cas difficiles, mais fut incapable de soulever l’enthousiasme pour sa « méthode Fell" ventilatoire. Ses rapports au congrès de Washington sur des sauvetages réussis rencontrèrent la dérision et l’indifférence, bien qu’il y soit détaillé la survie de 28 vies humaines après une intoxication aux opiacés en remplaçant la trachéotomie au profit d’un masque plus simple de pratique et avec peu de complications.

Poursuivant ses « sauvetages » tout au long des années 1890, Fell obtint personnellement des résultats probants après 73,5 heures (1896), et plus de 78 heures (1899). Il fit valoir sa méthode à plusieurs reprises avec de nombreuses conférences, beaucoup de documentations, et des plaidoyers pour l’utilisation de sa méthode dans d’autres crises ventilatoires. Malgré ses efforts et les réussites, Fell a été incapable d’obtenir l’adoption généralisée de la respiration forcée, mais d’autres ont adopté ses principes.

– Joseph O’Dwyer modifia le masque-trachéotomie de Fell en incorporant un tube intralaryngée, et cet « appareil de Fell-O’Dwyer " a été utilisé pour les cas de neurochirurgie (1894), et révolutionna la chirurgie intra-thoracique (1899)

La principale distinction du Dr Joseph O’Dwyer réside dans son dévouement et ses réalisations dans la lutte contre la diphtérie laryngée chez les enfants à l’asile de NewYork Foundling, où il exerça à partir de 1872. Il a également travaillé en pratique privée au Presbyterian Hospital de New York. Certains de ses travaux furent précurseurs des méthodes de traitements de la médecine de soins intensifs. Ses réalisations comprennent :

– Introduction d’un système pratique de l’intubation intralaryngée, y compris les dessins de tubes et une technique pour les insérer, après plusieurs années d’une étude minutieuse et d’expérimentation - toujours "sans inspiration empruntée".

– L’utilisation de ses tubes chez les enfants atteints de pseudomembranes diphtérique dans le larynx, d’accroître sensiblement leurs chances de survie à un moment où une trachéotomie pour faire face à ce problème avait encore un taux d’échec élevé. Le premier patient intubé récupéré, date de novembre 1882, seulement après le port prolongé d’un tube de trachéotomie, O’Dwyer ne date pas son succès d’intubation avant le 21 mai 1884.

– Introduction de ses tubes dans la méthode de la respiration forcée Fell, avec comme résultante l’appareil de Fell-O’Dwyer pour la ventilation à pression positive intermittente.

– La démonstration que cet appareil, principalement utilisé pour sauver des vies après une intoxication aiguë aux opiacés, a également été utile à certains traumatismes intracrâniens, (1894) par William P Northrup, en particulier. Bien que l’appareil a été utilisé au-delà de New York (par exemple, à la Nouvelle Orléans par JD Bloom, surtout pour l’apnée du nouveau-né), il est difficile de trouver d’autres références.

– Prestation d’un système, que d’autres ensuite appliqueront, qui permet aux chirurgiens de surmonter le grand « problème du pneumothorax" des opérations intra thoraciques, et ainsi procéder à une chirurgie sûre (1898) à l’initiative de Rodolphe Matas, dans la prestation de l’anesthésie et le maintien de l’inflation des poumons afin de permettre une chirurgie intra-thoracique (par FW Parham).

– Développement d’une méthode d’intubation à l’aide de courtes dilatations successives pour traiter la sténose laryngée chronique, habituellement syphilitique, chez les adultes, (1885)

Tout au long de son exercice médical, O’Dwyer a été tenue en haute estime comme un altruiste, une personne compatissante à la « simplicité sincère et franche, et une bonté de caractère".

Rodolphe Matas et Bloom améliorèrent le système original d’ O’Dwyer, mais après le succès clinique de l’insufflation continue pour la chirurgie thoracique de Charles Elsberg, en 1909, les anesthésistes américains en sont venus à préférer celle-ci.

– Dès 1887, l’appareil de Fell–O’Dwyer est le premier à être utilisé en pratique chirurgicale

– 1889, Head utilise des tubes trachéaux avec ballonnet gonflable pour ses expérimentations chez le chien.

– 1894 : Ventilation à pression positive après une intoxication de morphine par George Fell et Joseph O’Dwyer.

– 1895, Tuffier Tuffier invente un tube à ballonnet gonflable pour la ventilation en pression positive.

1895 : Description de la laryngoscopie directe par Alfred Kirstein inventeur de l’autoscope pour examiner le larynx et la trachée. Jusqu’alors, l’intubation trachéale était réalisée à l’aveugle.

– 1896 Killian invente une série d’instrument pour la bronchoscopie

-1898 Le premier appareil d’intubation et d’insufflation à l’usage

quotidien est dû à Doyen pour la chirurgie pulmonaire.

– 1901 : Franz Kuhn (1866-1929), un chirurgien allemand, est le premier à utiliser régulièrement l’intubation trachéale lors des anesthésies"Die intubation perorale". Mais cette pratique ne sera appliquée en routine hospitalière que bien plus tard, vers 1945

– 1909 Hill invente le premier laryngoscope à lame fendue

– 1911 Jackson permet l’intubation nasale sous contrôle direct, et Magill et Rowbotham préconisent l’intubation pour administrer une anesthésie. La technique se développe durant la Première Guerre mondiale dans le domaine de la traumatologie faciale avec l’utilisation de sondes en gomme.

– 1913 Chevalier Jackson décrit la technique actuelle d’intubation.

– 1913 Janeway invente les lames courbes.

– 1920 Magill et Rowbotham invente l’intubation nasale pour les traumatismes maxillofaciaux. Magill déterminera la forme courbe de la sonde d’intubation. (voir ces noms que l’on utilise)

– 1928 Flagg détermine la taille des tubes trachéaux

– 1931 Gale et Waters font la première intervention sur un seul poumon.

– 1943 Macintosh crée le laryngoscope actuel

– 1950 Bjork et Carlens invente la sonde trachéale à poumon séparé.

Depuis les années 1950, l’American society for testing materials définit les caractéristiques des tubes et du ballonnet.

Mais c’est à Matas que l’on doit le premier ventilateur moderne

La chirurgie thoracique posait le problème du pneumothorax et avant d’arriver à la ventilation en pression positive de nombreuses machines furent construites, allant de la pression négative au niveau du thorax à la pression positive.

– Les ventilateurs modernes en réanimation commencent par l’Engström 150 créé à la suite de l’épidémie de poliomyélite de 1954 en Suède.

– En 1970, l’électronique entre dans le fonctionnement des ventilateurs avec le Servo 900

- Les sondes d’intubation sont généralement en PVC, qui est un matériau bien toléré, transparent, non toxique, sans latex et à la particularité d’être thermoplastique, en s’adaptant à la température du corps et donc à la voie aérienne, de façon à favoriser la tolérance. Par contre en cas d’intubation difficile ou plus exactement en cas d’introduction itérative, elles deviennent rapidement molles et difficilement orientables. Dans ces conditions il convient de les rigidifier avec un mandrin.

- Silicone : beaucoup plus douce, son utilisation est recommandée pour l’intubation prolongée.

- caoutchouc souple : il faut proscrire l’utilisation de sondes réutilisables en caoutchouc.

- Acier inoxydable : à l’épreuve du feu, utilisé dans la chirurgie au laser .

Les ballonnets utilisés sont dits à basse pression, de façon à diminuer les risques d’ischémie muqueuse

La sonde se compose d’un tube, d’un système de connexion de diamètre standardisé appelé slip joint. Sur les sondes armées, le slip joint est solidaire de la sonde, sauf pour les sondes destinées aux Fastrach.

Les sondes à ballonnet commencent à la taille trois, les sondes standard peuvent être utilisées en oro ou naso trachéal.

Il existe une perforation latérale au delà du ballonnet que l’on appelle l’œil de Murphy qui assure le passage de l’air si le biseau est obstrué par contact avec la paroi.

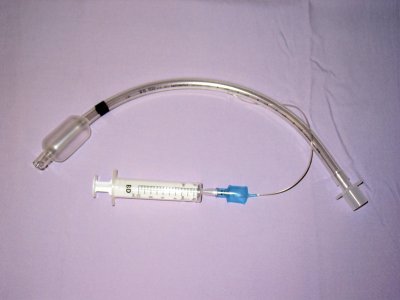

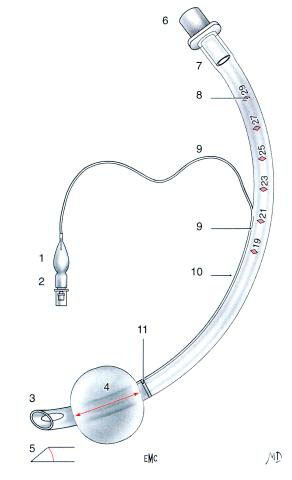

- 1. Ballonnet témoin ;

- 2. valve de gonflage ;

- 3. extrémité patient (distale) ;

- 4. longueur du ballonnet ;

- 5. angle du biseau ;

- 6. raccord ;

- 7. extrémité machine (proximale) ;

- 8. graduations de longueur ;

- 9. canal de gonflage ;

- 10. angle de courbure ;

- 11. repère de positionnement

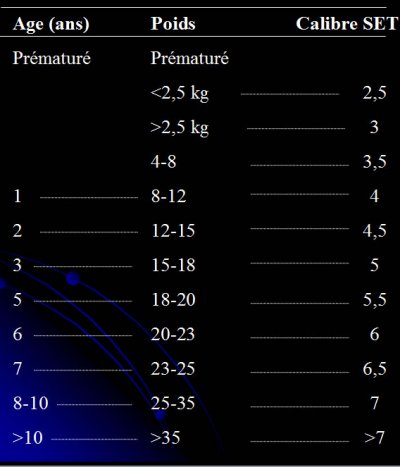

Quel diamètre choisir ?

(source intubation.fr)

Le numéro associé à une sonde intubation indique son diamètre interne, par contre le diamètre externe varie en fonction de la marque et du type de sonde.

Le diamètre externe est important chez enfant, la norme veut que ce chiffre soit mentionné sur les sondes de petite taille jusque taille 6

En fonction de l’âge, la formule de calcul varie en fonction de la présence d’un ballonnet

– Prématuré

Sonde de Cole, conçue pour l’intubation des nouveau-nés, avec un diamètre plus petit à son tiers inférieur, qui a la fonction de réduction de la résistance d’écoulement d’air lors de la ventilation mécanique.

- <2,5 kg => taille 2,5 sans ballonnet

- >2,5 kg => taille 3 sans ballonnet

– Puis pour les sondes sans ballonnet

- 4 à 8 Kg => taille 3,5 sans ballonnet (3 avec ballonnet)

- 8 à 12 kg => taille 4 sans ballonnet ( 3,5 avec ballonnet)

– Au-delà de 2 ans, choix du diamètre interne :

- Avec ballonnet D.I. mm. = (âge en années /4) + 3

- Sans ballonnet (D.I. mm.) = (âge en années /4) + 4

pour les sondes endotrachéales sans ballonnet, la formule retenue est

Diamètre = (age + 16) / 4

– Pour les sondes à ballonnet, on peut également appliquer la formule de Khine

Taille = (age /4) + 3

– Ou la formule de Cole : DI (mm)= âge/4 + 4 chez les enfants de plus de 2 ans

– Ou la formule de Khine modifiée : DI (mm)= âge/4 + 3,5

A lire

Résistance et travail respiratoire

La Sonde d’intubation représente une charge mécanique surtout en ventilation spontanée

La résistance et le travail ventilatoire sont augmentés par divers facteurs.

- Diamètre interne (sonde et raccord)

- Épaisseur paroi / même diamètre externe, ce rapport augmente dans les petites tailles (enfant)

- Introduction sonde aspiration, oxygène ou fibroscope

- Longueur : la réduction de la longueur diminue la résistance (< diamètre)

- Configuration des lignes associées à la sonde : Coudes et raccords augmentent la résistance

- Densité du gaz

– Les types de sonde

Traditionnelles

pour en connaître l’invention, lire eurékiade

Tube Parker (Parker médical, Englewood, CO, USA) : le Flex-Tip a un bec en forme de morphologie particulière, avec 2 trous de Murphy. L’œil de Murphy augmente le risque de traumatisme des cornets lors de l’ intubation nasale. On parle de pointe de Magill lorsque l’œil de Murphy est absent.

Les sondes avec mandrin prémonté

- Taille > 5

- Mandrin de taille toujours adaptée

Indication

o Pays chauds

o Systématique

Sondes préformées orales

Tube oral RAE (Ring-Adair-Elwin) : Utilisé dans les intubations orales pour chirurgie dentaire. Formé d’un " U " qui descend vers le thorax.

- Utilisées en chirurgie faciale

- leur insertion peut se faire avec un mandrin court pour faciliter la mise en place

- Taille adulte et enfant

La sonde d’Oxford, conçue par Alsop en 1955. En forme de "L" et a été créée dans le but d’éviter la plicature des tubes pour effectuer des procédures chirurgicales de la tête et du cou.

Sondes préformées nasales

Tube nasal RAE : Conçu avec le même but que ci-dessus mais pour les intubations nasales, libérant ainsi la cavité buccale.

- Utilisées en chirurgie de la bouche

- Sondes longues à fixer sur le front

- ne permettent pas l’aspiration endotrachéale

Sonde armée

- Comporte une spirale métallique qui empêche la compression extrinsèque du tube

- Slip Joint collé (sauf sonde fastrach)

• Indication

- Risque de compression en per opératoire ou en médecine d’urgence

- Mobilisation de la tête per opératoire

- Intubation sous fibroscopie

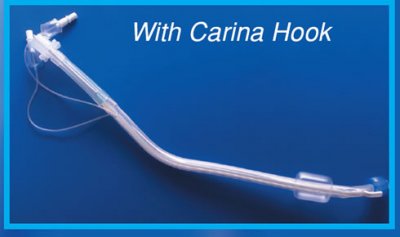

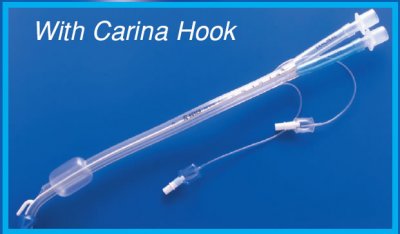

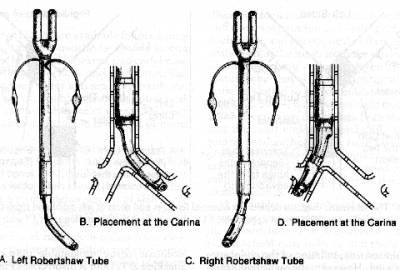

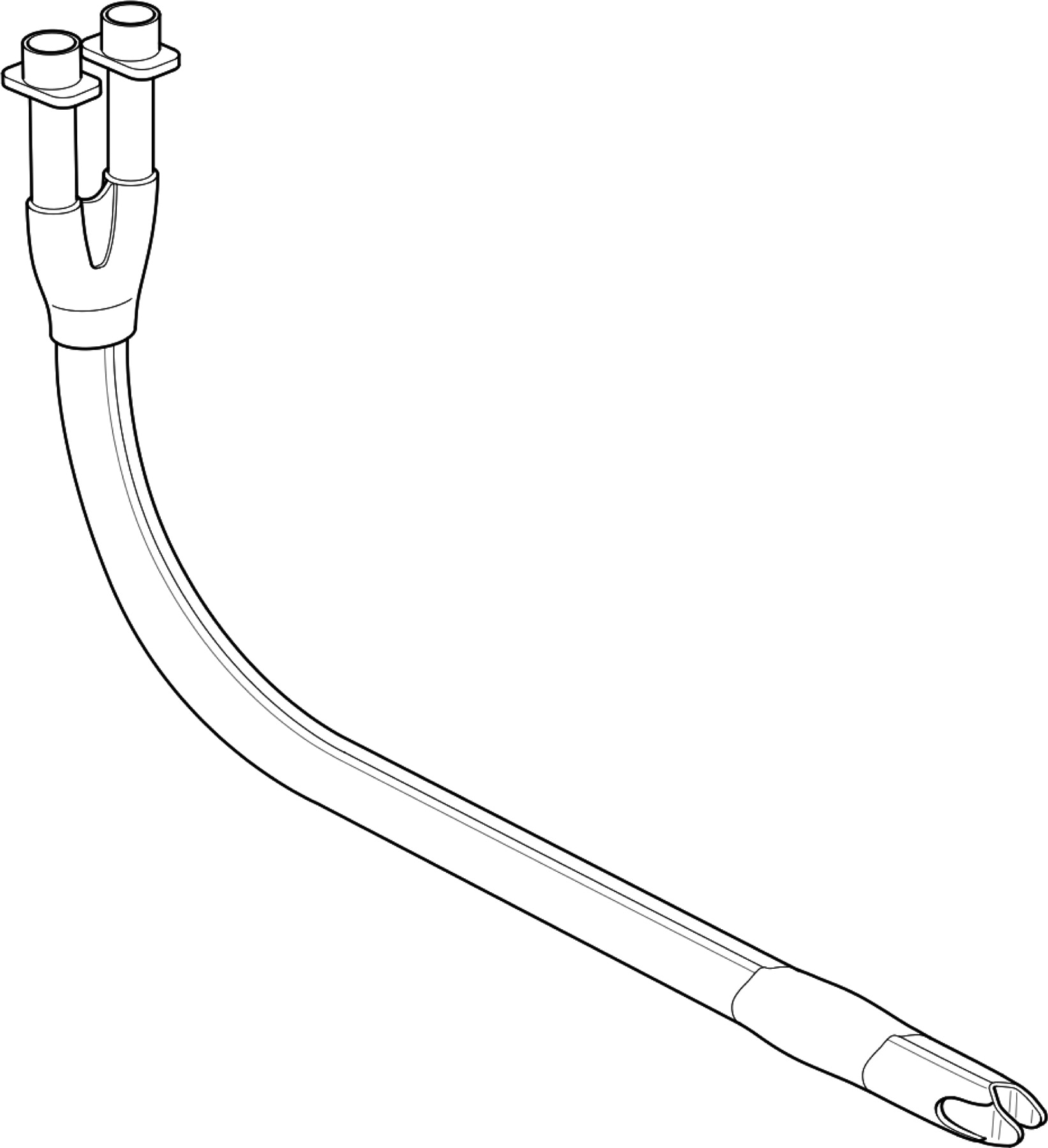

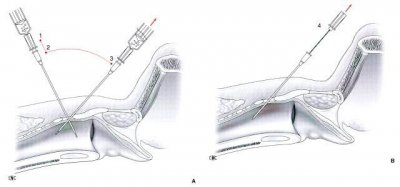

Sondes bronchiques à double lumière

• Indications :

- nécessité isoler un poumon de l’autre

- Ventilation ou aspiration un seul poumon

- Ventilation séparée de chaque poumon PEP unilatérale-*

• Sondes :

- 2 tubes juxtaposées

- Tube trachéal se termine au dessus de la carène

- Tube bronchique cathétérise la bronche appropriée

- Partie distale forme un angle qui s’oriente vers la bronche

- 2 versions : droite ou gauche

- Possibilités d’un ergot qui favorise le placement et réduit les mouvements

- Ballonnets : au moins 2

- Trachéal : au dessus orifice trachéal

- Bronchique : au dessus de la terminaison du tube

Gonflage indépendant

– Sonde de Carlens

- Pour intubation bronche souche gauche

- Ergot +

- 6 tailles : 28, 32, 35, 37, 39, 41 French

– Sonde de White

- Pour intubation bronche souche droite

- Ergot +

- 6 tailles : 28, 32, 35, 37, 39, 41 French

– Sonde de Robertshaw

- Pour intubation gauche ou droite, sans ergot.

- 6 tailles : 28, 32, 35, 37, 39, 41 French

Double-Lumen Catheter Intubation - Medical Animation

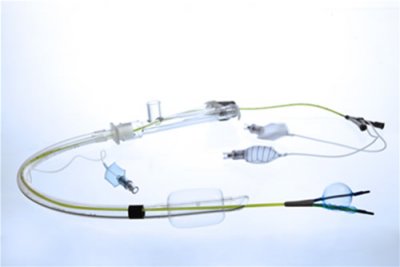

– Bloqueur bronchique

EZ block (laboratoires Rüsh)

Atraumatique

- mise en place rapide et sûre en association avec une sonde endotrachéale standard

- complètement radio-opaque

- ses 2 ballonnets distaux en polyuréthane procurent une étanchéité douce et optimale

- évite la ré-intubation après le retrait d’EZ-Blocker en cas de ventilation post-opératoire nécessaire

Forme en Y

- sécurité accrue : EZ-Blocker se positionne de lui-même sur la carène

- s’apparente à la bifurcation naturelle de la trachée et réduit le risque de déplacement en cours d’intervention ou lors de re-positionnement du patient

L’EZ-Blocker est une solution qui facilite la plupart des procédures thoraciques et le traitement des pathologies pulmonaires, de la paroi thoracique et du diaphragme. Il a été conçu pour être utilisé en Chirurgie Thoracique en Vidéo-Assistée (CTVA).

avec affaissement du poumon.

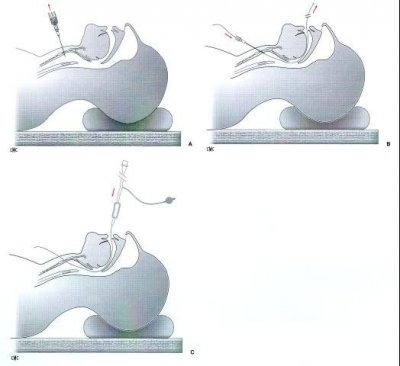

- Papworth BiVent Tube

Le tube Papworth BiVent est un dispositif à usage unique constitué d’un matériau de caoutchouc avec deux lumières en forme de D, agencées dans une configuration côte-à-côte, séparées par une cloison centrale. Le tube a une concavité préformée postérieure unique et une seule gonflable, à haut volume, basse pression trachéale. À l’extrémité distale deux pointes forment une pointe en forme de fourche. Le tube a été conçu pour être positionné avec cette pointe fourchue assise sur la carène.

Le tube BiVent Papworth.

Le corps principal du prototype est elliptique en section transversale avec des rayons externe de 10 et 17 mm. Les dimensions intérieures des lumières en forme de D sont 5 × 3,5 mm.

Le tube Papworth BiVent, a été conçu pour permettre l’isolement des poumons, de façon rapide et fiable en utilisant n’importe quel bloqueur bronchique sans avoir besoin de guidage endoscopique par fibre optique.

L’intubation trachéale avec le tube Papworth BiVent s’est avéré être plus facile qu’avec un tube de lumière double classique endobronchique.

L’isolement du poumon avec le tube BiVent Papworth utilisé en combinaison avec un inhibiteur bronchique a été réalisée de manière fiable et plus rapide qu’avec un tube à une seule lumière et bloquant bronches.

The Papworth BiVent tube : a feasibility study of a novel double-lumen endotracheal tube and bronchial blocker in human cadavers

S. Ghosh1,*†, A. A. Klein1, M. Prabhu2, F. Falter1 and J. E. Arrowsmith1

Ventilating in isolation : the Papworth BiVent tube

The Papworth BiVent tube : a new device for lung isolation.

FIXATION SÉCURISÉE DE LA SONDE D’INTUBATION

Docteur Eric TORRES

- SDIS 13 / revue@urgence-pratique.com

Docteur Eric ROYER

- Grimp 14 / urgence.com

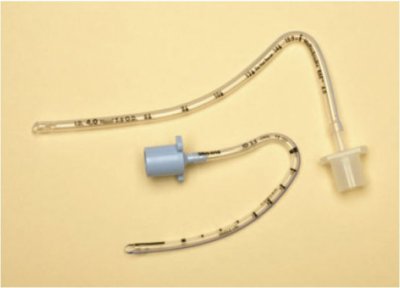

Les médecins amenés à intervenir dans le cadre des secours en milieu périlleux (GRIMP, secours en montagne) sont parfois confrontés au risque d’extubation accidentelle du patient lors de la réalisation de manœuvres de brancardage particulièrement longues ou techniques.

Le ballonnet de la sonde d’intubation ne sert qu’à assurer l’étanchéité entre la sonde d’intubation et la trachée (ventilation sans fuite, protection des voies aériennes contre l’inhalation accidentelle du contenu gastrique). Il n’a aucun rôle de fixation ou de maintien de la sonde en position correcte. La fixation de la sonde d’intubation doit donc être assurée par un moyen « externe » comme une « cravate » de sparadrap collée sur le maxillaire supérieur (partie fixe de la mâchoire) ou un lacs passé autour de la tête du patient. Nous nous proposons de décrire ici une technique permettant d’optimiser ces moyens de fixation afin de limiter le risque d’extubation accidentelle lorsque le patient doit être mobilisé.

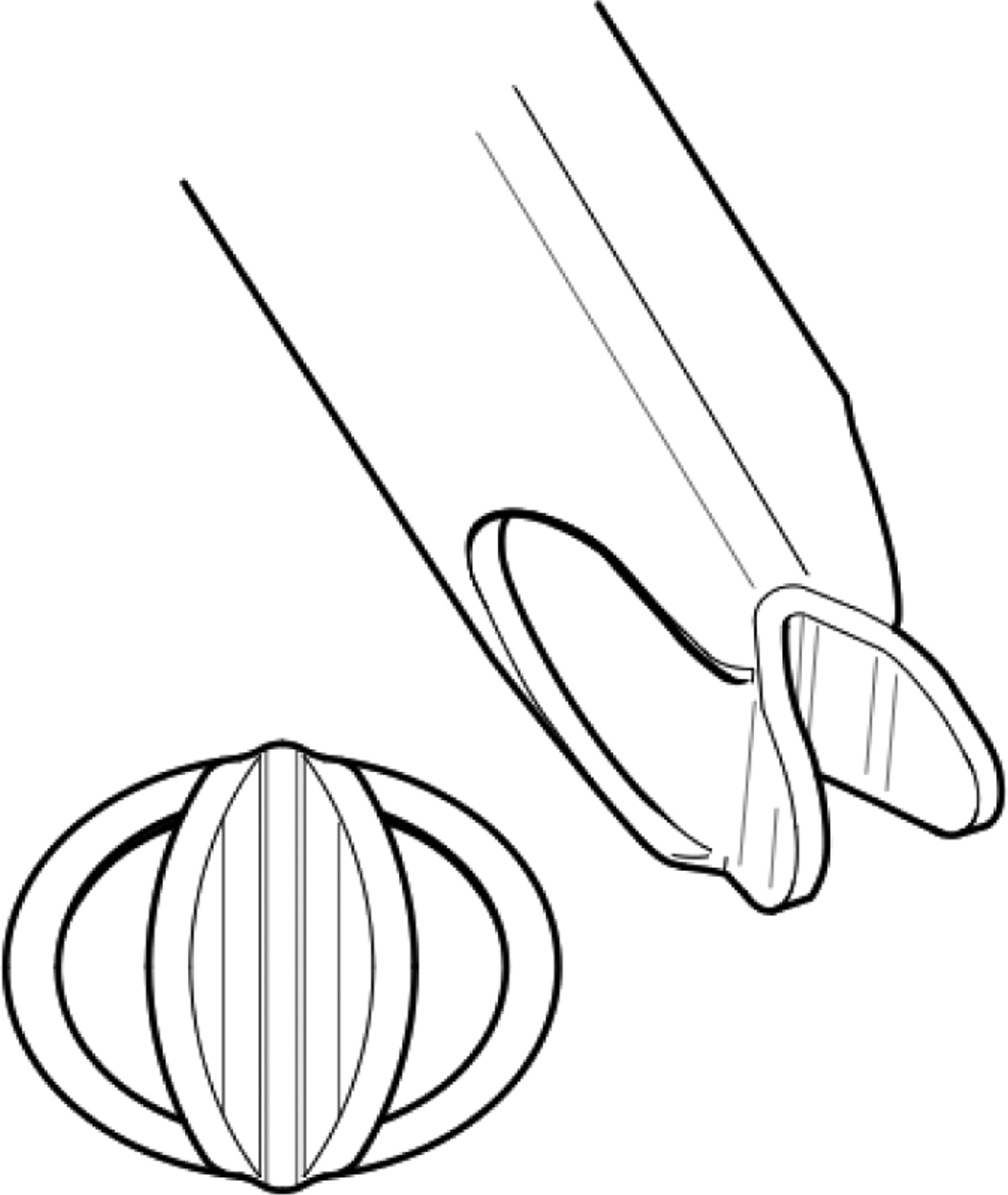

- TECHNIQUE

La technique préconisée consiste à augmenter le diamètre du lien afin de pouvoir serrer plus étroitement le dispositif contre le visage du patient sans risquer de provoquer de lésions. Pour cela les auteurs conseillent d’utiliser un lacs traditionnel (ou un lacet) introduit au travers d’une seconde sonde d’intubation dans laquelle on aura pris soin de réaliser un orifice latéralisé du côté de la concavité, dans sa courbure au niveau de sa partie médiane. Le lien sera disposé de manière à faire une boucle après le franchissement de cet orifice afin de maintenir fermement la sonde d’intubation au contact du dispositif de fixation ainsi réalisé (voir photo). L’ensemble sera solidarisé au patient par un nœud.

– VARIANTES

En fonction des habitudes de l’opérateur et des moyens dont il dispose il pourra utiliser à la place du lacs un lacet ou un autre type de lien. La sonde d’intubation servant à protéger ce lien pourra être remplacée par une portion de sonde gastrique ou par un morceau de tubulure à oxygène.

– AVANTAGES

Ce mode de fixation, particulièrement résistant, permet d’éviter à la fois l’extubation malencontreuse (traction sur la sonde) et le risque d’intubation sélective secondaire (enfoncement de la sonde). Il résiste à des tractions accidentelles de plusieurs kilos qui peuvent parfois se produire lors de la prise en charge en terrain difficile (brancardage long et technique). Cette technique est utilisable sur le sujet barbu ou en sueur (hypercapnie), contrairement à la fixation traditionnelle au sparadrap. Enfin, l’utilisation de sondes d’intubations ayant dépassé la date de péremption pour réaliser ce dispositif de fixation rend son coût pratiquement nul.

– INCONVENIENTS

Afin de ne pas perdre de temps lors de l’intervention, ce dispositif de fixation doit être préparé à l’avance. Il prendra ensuite peu de place dans le compartiment « intubation » du sac d’intervention.

Ce montage est uniquement destiné à être utilisé dans certaines situations extra hospitalières « difficiles ». Il ne doit pas être laissé en place trop longtemps pour éviter d’irriter la visage (commissures labiales, joues) de la victime. Il n’est pas destiné à être utilisé systématiquement lors des interventions en situation conventionnelle et encore moins à l’hôpital ou les méthodes de fixation classiques sont amplement suffisantes.

Enfin, cette technique ne dispense pas de la règle habituelle de prudence qui consiste à vérifier par l’auscultation la bonne position de la sonde après chaque mobilisation du patient comme le rappelle l’aphorisme :

« patient intubé et mobilisé = patient ausculté ».

– CONCLUSION

La technique décrite nous paraît simple et efficace. Elle nous semble particulièrement adaptée aux besoins de la médicalisation en milieux périlleux. Nous avons eu l’occasion de la tester à plusieurs reprises dans le cadre du secours en paroi (évacuation d’un patient sur perche Piguilhem) ou du secours sur piste (évacuation d’un patient en barquette). Dans tous les cas, elle nous a donné entière satisfaction.

-LA TRACHEOTOMIE

Dr D.Rouland (Médecin Urgentiste, Spécialiste en ORL) (source smur argenteuil)

Technique chirurgicale nécessitant une grande rigueur d’exécution, la trachéotomie se pratique dans des contextes très différents et tout à fait opposés.

Nous nous attacherons donc à décrire les principes les principes de bases, communs à toutes les circonstances où son indication ne fait aucune discussion, puis nous détaillerons les modes opératoires propres à chacune.

Cependant, avant de parler de la technique elle-même, nous ferons un rappel anatomique de la région, rapide et succinct.

Enfin, nous donnerons les principales indications et nous discuterons les alternatives à ce geste qui nous sont proposées avec leurs principaux avantages et leurs inconvénients.

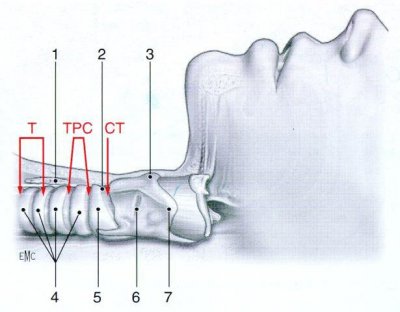

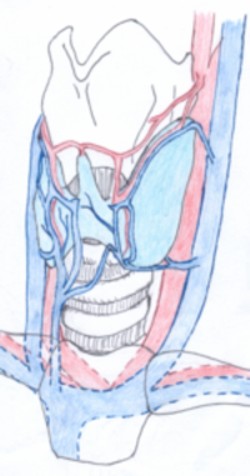

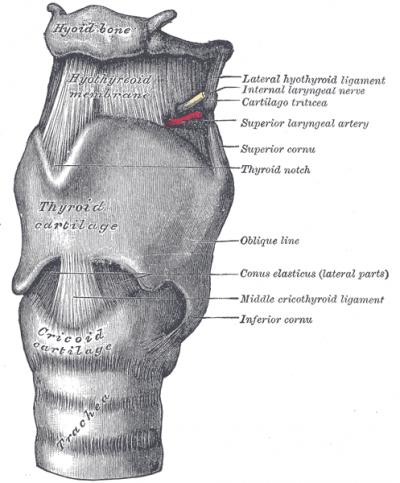

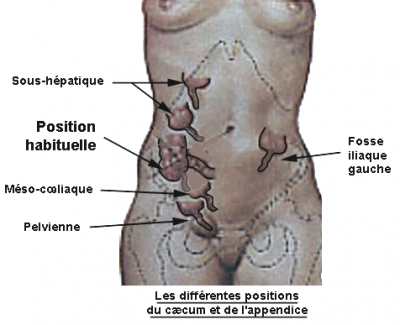

Rappel anatomique :

La région qui nous intéresse se situe à la face antérieure du cou, limitée en haut par la saillie du cartilage thyroïde, en bas par la fourchette manubriale, et de part et d’autre, par le chef antérieur du sterno-cleïdo-mastoïdien droit et gauche.

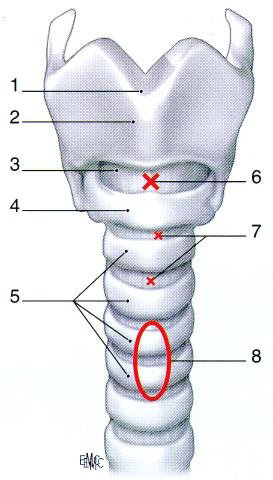

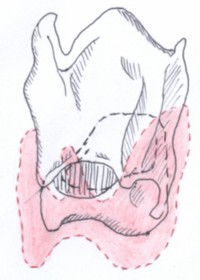

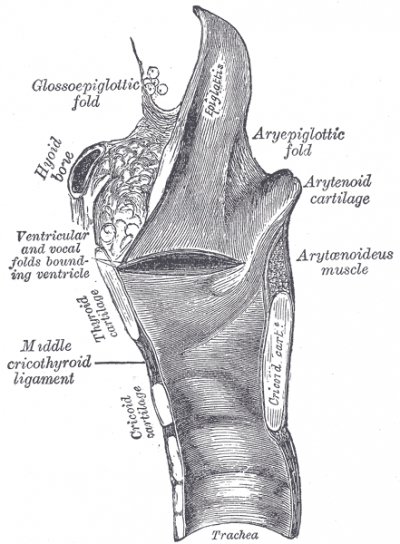

cartilages thyroïde et cricoïde

Il est important de connaître les rapports de l’axe aérien sur son trajet dans le secteur que nous venons de délimiter, ainsi que sa structure.

1) Structure de l’axe aérien :

Le premier élément de cet axe est le cartilage thyroïde.